En théorie des probabilités et en statistique, la loi inverse-gaussienne (ou loi gaussienne inverse ou encore loi de Wald) est une loi de probabilité continue à deux paramètres et à valeurs strictement positives. Elle est nommée d'après le statisticien Abraham Wald.

Le terme « inverse » ne doit pas être mal interprété, la loi est inverse dans le sens suivant : la valeur du mouvement brownien à un temps fixé est de loi normale, à l'inverse, le temps en lequel le mouvement brownien avec une dérive positive (drifté) atteint une valeur fixée est de loi inverse-gaussienne.

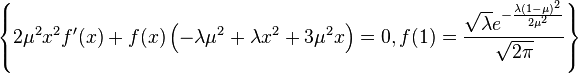

Sa densité de probabilité est donnée par

où μ > 0 est son espérance et λ > 0 est un paramètre de forme.

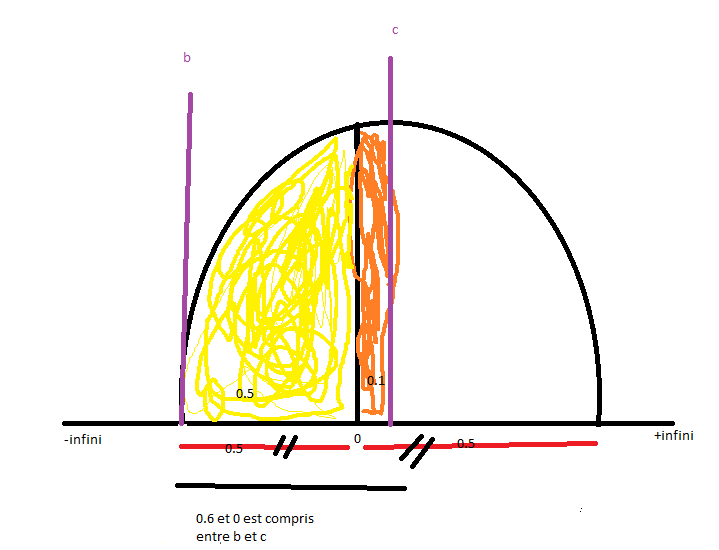

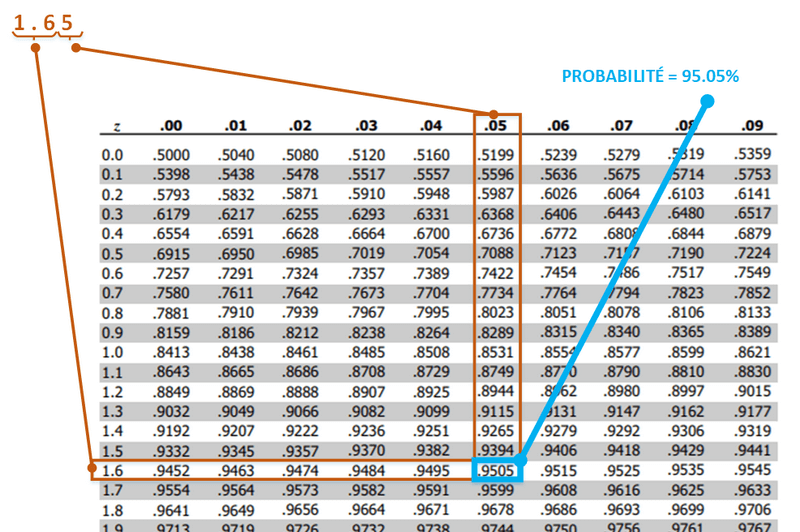

Lorsque λ tend vers l'infini, la loi inverse-gaussienne se comporte comme une loi normale, elle possède plusieurs propriétés similaires avec cette dernière.

La fonction génératrice des cumulants (logarithme de la fonction caractéristique) de la loi inverse-gaussienne est l'inverse de celle de la loi normale.

Pour indiquer qu'une variable aléatoire X est de loi inverse-gaussienne de paramètres et , on utilise la notation

Propriétés

Somme

Si les variables aléatoires , ont pour loi respectivement, et sont indépendantes, alors leur somme est de loi inverse-gaussienne :

Il est à remarquer que

est constant pour tout i. C'est une condition nécessaire pour cette formule de sommation.

Échelle

Si X est de loi inverse-gaussienne, alors pour tout t > 0, tX est de loi inverse-gaussienne dont les paramètres sont multipliés par t :

Famille exponentielle

La loi inverse-gaussienne est une famille exponentielle à deux paramètres avec pour paramètres naturels et , et pour statistiques naturelles X et 1/X.

Lien avec le mouvement brownien

Le processus stochastique défini par

où est le mouvement brownien standard et ν > 0, est un mouvement brownien drifté par ν.

Ainsi, le temps d'atteinte (ou premier temps de passage) de la valeur (ou niveau) α > 0 fixé par X est aléatoire et de loi inverse-gaussienne :

Pour un drift nul

Un cas particulier usuel de l'explication précédente est le cas où le mouvement brownien n'a pas de drift. Dans ce cas, le paramètre μ tend vers l'infini, et le temps d'atteinte d'une valeur α < 0 fixée est une variable aléatoire de densité de probabilité celle de la distribution de Lévy avec paramètre :

Maximum de vraisemblance

Considérons le modèle donné par

où tous les wi sont connus, sont inconnus et où les variables indépendantes Xi ont pour fonction de vraisemblance :

En résolvant l'équation de vraisemblance, on obtient les estimées suivantes :

et sont indépendants et

Simulation numérique de la loi inverse-gaussienne

L'algorithme suivant peut être utilisé pour générer des valeurs de la loi inverse-gaussienne.

- Prendre

- et

- et .

- Prendre

- Si retourner

- Sinon retourner

Liens avec d'autres lois

La convolution de la loi inverse-gaussienne et de la loi exponentielle est utilisée comme modélisation du temps de réponse en psychologie. Elle est appelée loi ex-Wald.

Historique

Cette loi fut initialement utilisée par Erwin Schrödinger en 1915 comme temps d'atteinte du mouvement brownien. Le nom « inverse-gaussienne » (inverse Gaussian en anglais) fut proposé par Tweedie en 1945. Abraham Wald réutilise cette loi en 1947 comme la forme limite d'un échantillon dans un test. Tweedie détaille des propriétés statistiques de cette loi en 1957.

Logiciel

Le langage de programmation R possède cette loi,.

Notes et références

Références

- The inverse gaussian distribution: theory, methodology, and applications by Raj Chhikara and Leroy Folks, 1989 (ISBN 0-8247-7997-5)

- System Reliability Theory by Marvin Rausand and Arnljot Høyland

- The Inverse Gaussian Distribution by Dr. V. Seshadri, Oxford Univ Press, 1993

Liens externes

- (en) Eric W. Weisstein, « Inverse Gaussian Distribution », sur MathWorld

- Portail des probabilités et de la statistique